Ésta práctica fue muy fácil aunque varios de mis compañeros tuvieron dificultades para realizarla, pero en mi experiencia al haberla realizado es que para esta práctica se requiere de paciencia.

Que sea fácil no significa que no sea compleja, porque se tuvo que usar un poco de destreza al dejar los cables dentro del cable de red sin dañarlos para conectarlos a el conector RJ45, al igual de que estos cables al extraerlos tienen un orden antes de insertarlos en el conector. Por lo que esta practica termina siendo en mi opinion muy útil tal vez para un futuro cercano o tal vez en mi presente.

Portafolio de evidencias de TICS

lunes, 30 de noviembre de 2015

jueves, 26 de noviembre de 2015

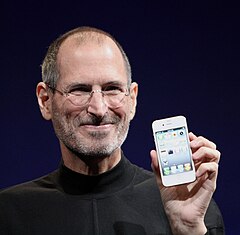

Steve Jobs

Fundó Apple en 1976 junto con un amigo de la adolescencia, Steve Wozniak, en el garaje de su casa. Aupado por el éxito del Apple II Jobs obtuvo una gran relevancia pública, siendo portada de Time en 1982.14 Contaba 26 años y ya era millonario gracias a la exitosa salida a bolsa de la compañía a finales del año anterior. La década de los 80 supuso la entrada de potentes competidores en el mercado de los ordenadores personales, lo que originó las primeras dificultades empresariales. Su reacción fue innovar, o mejor dicho, implementar: a principios de 1984 su compañía lanzaba el Macintosh 128K, que fue el primer ordenador personal que se comercializó exitosamente que usaba una interfaz gráfica de usuario (GUI) y un ratón en vez de la línea de comandos. Después de tener problemas con la cúpula directiva de la empresa que el mismo fundó, renunció.15 Jobs vendió entonces todas sus acciones, salvo una. Ese mismo año recibía la Medalla Nacional de Tecnología del presidente Ronald Reagan, cerrando con este reconocimiento esta primera etapa como emprendedor. Regresó en 1997 a la compañía, que se encontraba en graves dificultades financieras, y fue su director ejecutivo hasta el 24 de agosto de 2011.16 17 18 19 En ese verano Apple sobrepasó a Exxon como la empresa con mayor capitalización del mundo.20Steven Paul Jobs (San Francisco, California, 24 de febrero de 1955-Palo Alto, California, 5 de octubre de 2011),8 9 10 11 más conocido como Steve Jobs, fue un empresario y magnate de los negocios del sector informático y de la industria del entretenimiento estadounidense. Fue cofundador y presidente ejecutivo de Apple Inc.12 y máximo accionista individual de The Walt Disney Company.13

Fundó Apple en 1976 junto con un amigo de la adolescencia, Steve Wozniak, en el garaje de su casa. Aupado por el éxito del Apple II Jobs obtuvo una gran relevancia pública, siendo portada de Time en 1982.14 Contaba 26 años y ya era millonario gracias a la exitosa salida a bolsa de la compañía a finales del año anterior. La década de los 80 supuso la entrada de potentes competidores en el mercado de los ordenadores personales, lo que originó las primeras dificultades empresariales. Su reacción fue innovar, o mejor dicho, implementar: a principios de 1984 su compañía lanzaba el Macintosh 128K, que fue el primer ordenador personal que se comercializó exitosamente que usaba una interfaz gráfica de usuario (GUI) y un ratón en vez de la línea de comandos. Después de tener problemas con la cúpula directiva de la empresa que el mismo fundó, renunció.15 Jobs vendió entonces todas sus acciones, salvo una. Ese mismo año recibía la Medalla Nacional de Tecnología del presidente Ronald Reagan, cerrando con este reconocimiento esta primera etapa como emprendedor. Regresó en 1997 a la compañía, que se encontraba en graves dificultades financieras, y fue su director ejecutivo hasta el 24 de agosto de 2011.16 17 18 19 En ese verano Apple sobrepasó a Exxon como la empresa con mayor capitalización del mundo.20Steven Paul Jobs (San Francisco, California, 24 de febrero de 1955-Palo Alto, California, 5 de octubre de 2011),8 9 10 11 más conocido como Steve Jobs, fue un empresario y magnate de los negocios del sector informático y de la industria del entretenimiento estadounidense. Fue cofundador y presidente ejecutivo de Apple Inc.12 y máximo accionista individual de The Walt Disney Company.13

Durante los años 90 transformó una empresa subsidiaria adquirida a Lucasfilm en Pixar, que revolucionó la industria de animación con el lanzamiento de Toy Story. La integración de esta compañía en Disney, de la que era proveedor, convertiría a Jobs en el mayor accionista individual del gigante del entretenimiento. En el año de su muerte, su fortuna se valoraba en 8.300 millones de dólares21 y ocupaba el puesto 110 en la lista de grandes fortunas de la revista Forbes.

En su segunda etapa en Apple, también cambió el modelo de negocio de la industria musical: aprobó el lanzamiento del iPod en 2001, y en 2003 la tienda online de música de iTunes, que en siete años vendió más de 10.000 millones de canciones y dominó completamente el negocio de música en línea, a un precio de US$0,99 por canción descargada.22 Ya en 2009 lograba acaparar el 25 por ciento de la venta de música en los Estados Unidos, y es la mayor tienda musical por volumen de ventas de la historia.Según el registro de patentes de los Estados Unidos, 317 patentes de Jobs figuran a nombre de Apple.

Primeros años

Steve Jobs nació en San Francisco (California) en el año 1955, fruto de la relación entre Abdulfattah Jandali, un inmigrante sirio musulmán, y Joanne Carole Schieble, una estadounidense de ascendencia suiza y alemana, dos jóvenes estudiantes universitarios que lo entregarían en adopción a una pareja de clase media, Paul y Clara Jobs (Hagopian) de origen armenio.25 26 28 Sus padres biológicos se casarían luego y tendrían otra hija, la novelista Mona Simpson, a quien Steve no conocería hasta la edad adulta.25

En esa nueva familia Steve creció junto a su otra hermana, Patty. Su padre, Paul Jobs, era maquinista para la compañía estatal de transporte ferroviario y su madre ama de casa.26

En 1961 la familia se trasladó a Mountain View,26 una ciudad al sur de Palo Alto que empezaba a convertirse en un centro importante de la industria de la electrónica. Allí asistió a la escuela primaria Cupertino Middle School y a la secundaria Homestead H.S., también en Cupertino.28 A Jobs le interesaban bastante la electrónica y los gadgets, razón que le llevó a unirse a un club llamado Hewlett-Packard Explorer Club, donde ingenieros de Hewlett-Packard mostraban a los jóvenes sus nuevos productos. Fue allí donde Steve vio su primera computadora, a la edad de 12 años. Quedó tan impresionado que supo de inmediato que él quería trabajar con computadores.

Ya en la secundaria asiste a charlas de Hewlett-Packard. En una ocasión, Steve preguntó al por entonces presidente de la compañía, William Hewlett, sobre algunas partes que necesitaba para completar un proyecto de clase. William quedó tan impresionado que se las proporcionó y le ofreció realizar unas prácticas de verano en su compañía.26 25Steve sería luego contratado como empleado veraniego, coincidiendo allí con Steve Wozniak por medio de un amigo mutuo, Bill Fernandez.29

En 1972 entra en la universidad Reed College de Portland (Oregón). Asiste a ella tan solo 6 meses antes de abandonarla, debido al alto coste de sus estudios.En lugar de regresar a casa, continúa asistiendo a clases como oyente unos 18 meses más, viviendo a base de trabajos con ingresos ínfimos. Curiosamente, sus estudios en caligrafía le serían de utilidad cuando diseñara las tipografías del primer Mac.

Tras dos años fuera de casa, en otoño de 1974 regresa a California con el objetivo de realizar un retiro espiritual en la India y consigue un trabajo como técnico en la empresa fabricante de juegos de video Atari Inc..,26 donde colaboró en la creación del juego Breakout. De la mano de Steve Wozniak comienza a asistir a la reuniones del Homebrew Computer Club, donde Wozniak le contó que estaba intentando construir un pequeño computador casero.26 27 Jobs se mostró especialmente fascinado con las posibilidades mercantiles de la idea de Wozniak y le convence para fabricar y vender uno. Steve Jobs se encarga de las ventas y negociaciones y Steve Wozniak, en secreto, de construir la máquina electrónica.30

Según afirma Nolan Bushnell, luego de su regreso de la India a donde fue acompañado por un antiguo compañero de la escuela secundaria, y más tarde primer empleado de Apple, Daniel Kottke,25 decidió renunciar a Atari y fundar Apple Computer, Steve ofreció a Bushnell un porcentaje de Apple, 50.000 dólares, el cual no aceptó.31 Durante este tiempo, experimentó con drogas psicodélicas, LSD, llamando a sus experiencias como "una de las dos o tres cosas más importantes que había hecho en su vida".32

Generaciones anteriores y actuales de los celulares

Los inicios (0G): Los pioneros

Los primeros sistemas de telefonía móvil civil empiezan a desarrollarse a partir de finales de los años 40 en los Estados Unidos. Eran sistemas de radio analógicos que utilizaban en el primer momento modulación en amplitud (AM) y posteriormente modulación en frecuencia (FM). Se popularizó el uso de sistemas FM gracias a su superior calidad de audio y resistencia a las interferencias. El servicio se daba en las bandas de HF y VHF.

Los primeros equipos eran enormes y pesados, por lo que estaban destinados casi exclusivamente a su uso a bordo de vehículos. Generalmente se instalaba el equipo de radio en el maletero y se pasaba un cable con el teléfono hasta el salpicadero del coche.

Una de las compañías pioneras que se dedicaron a la explotación de este servicio fue la americana Bell. Su servicio móvil fue llamado Bell System Service.

No era un servicio popular porque era extremadamente caro, pero estuvo operando (con actualizaciones tecnológicas, por supuesto) desde 1946 hasta 1985.

Primera generación (1G): Maduración de la idea

En 1981 el fabricante Ericsson lanza el sistema NMT 450 (Nordic Mobile Telephony 450 MHz). Este sistema seguía utilizando canales de radio analógicos (frecuencias en torno a 450 MHz) con modulación en frecuencia (FM). Era el primer sistema del mundo de telefonía móvil tal como se entiende hoy en día.

La primera generación de Teléfonos Celulares se caracterizo por ser analógica y exclusivamente para llamadas de VOZ.

Los equipos 1G pueden parecer algo aparatosos para los estándares actuales pero fueron un gran avance para su época, ya que podían ser trasladados y utilizados por una única persona.

En 1986, Ericsson modernizó el sistema, llevándolo hasta el nivel NMT 900. Esta nueva versión funcionaba prácticamente igual que la anterior pero a frecuencias superiores (del orden de 900 MHz). Esto posibilitó dar servicio a un mayor número de usuarios y avanzar en la portabilidad de los terminales.

Además del sistema NMT, en los 80 se desarrollaron otros sistemas de telefonía móvil tales como: AMPS (Advanced Mobile Phone System) en EE. UU. y TACS (Total Access Comunication System).

El sistema TACS se utilizó en España con el nombre comercial de MoviLine. Estuvo en servicio hasta su extinción en 2003.

Segunda generación (2G): Popularización

En la década de 1990 nace la segunda generación, que utiliza sistemas como GSM, IS-136, iDEN e IS-95. Las frecuencias utilizadas en Europa fueron de 900 y 1800 MHz.

La segunda generación se diferencia de la primera principalmente por el serviciodigital. Estas soportan velocidades de información más altas para el servicio de voz, pero limitadas en comunicación de datos, o sea que permite SMS (Short MessageService) a diferencia de la primera generación.

El desarrollo de esta generación tiene como piedra angular la digitalización de las comunicaciones. Las comunicaciones digitales ofrecen una mejor calidad de voz que las analógicas, además se aumenta el nivel de seguridad y se simplifica la fabricación del Terminal (con la reducción de costes que ello conlleva). En esta época nacen varios estándares de comunicaciones móviles: D-AMPS (EE. UU.), PDC(Japón), cdmaOne (EE. UU. y Asia) y GSM.

Muchas operadoras telefónicas móviles implementaron Acceso múltiple por división de tiempo (TDMA) y Acceso múltiple por división de código (CDMA) sobre las redesAmps existentes convirtiéndolas así en redes D-AMPS. Esto trajo como ventaja para estas empresas poder lograr una migración de señal analógica a señal digital sin tener que cambiar elementos como antenas, torres, cableado, etc. Inclusive, esta información digital se transmitía sobre los mismos canales (y por ende, frecuencias de radio) ya existentes y en uso por la red analógica. La gran diferencia es que con la tecnología digital se hizo posible hacer Multiplexion, tal que en un canal antes destinado a transmitir una sola conversación a la vez se hizo posible transmitir varias conversaciones de manera simultánea, incrementando así la capacidad operativa y el número de usuarios que podían hacer uso de la red en una misma celda en un momento dado.

El estándar que ha universalizado la telefonía móvil ha sido el archiconocido GSM: Global System for Mobile communications o Groupe Spécial Mobile. Se trata de un estándar europeo nacido de los siguientes principios:

- Buena calidad de voz (gracias al procesado digital).

- Itinerancia.

- Deseo de implantación internacional.

- Terminales realmente portátiles (de reducido peso y tamaño) a un precio asequible.

- Compatibilidad con la RDSI (Red Digital de Servicios Integrados).

- Instauración de un mercado competitivo con multitud de operadores y fabricantes.

Realmente, GSM ha cumplido con todos sus objetivos pero al cabo de un tiempo empezó a acercarse a la obsolescencia porque sólo ofrecía un servicio de voz o datos a baja velocidad (9.6 Kbps) y el mercado empezaba a requerir servicios multimedia que hacían necesario un aumento de la capacidad de transferencia de datos del sistema. Es en este momento cuando se empieza a gestar la idea de 3G, pero como la tecnología CDMA no estaba lo suficientemente madura en aquel momento se optó por dar un paso intermedio: 2.5G.

Generación de transición (2.5G)

Dado que la tecnología de 2G fue incrementada a 2.5G, en la cual se incluyen nuevos servicios como EMS y MMS:

- EMS es el servicio de mensajería mejorado, permite la inclusión de melodías e iconos dentro del mensaje basándose en los sms; un EMS equivale a 3 o 4 sms.

- MMS (Sistema de Mensajería Multimedia) Este tipo de mensajes se envían mediante GPRS y permite la inserción de imágenes, sonidos, videos y texto. Un MMS se envía en forma de diapositiva, en la cual cada plantilla solo puede contener un archivo de cada tipo aceptado, es decir, solo puede contener una imagen, un sonido y un texto en cada plantilla, si de desea agregar más de estos tendría que agregarse otra plantilla. Cabe mencionar que no es posible enviar un vídeo de más de 15 segundos de duración.

Para poder prestar estos nuevos servicios se hizo necesaria una mayor velocidad de transferencia de datos, que se hizo realidad con las tecnologías GPRS y EDGE.

- GPRS (General Packet Radio Service) permite velocidades de datos desde 56kbps hasta 114 kbps.

- EDGE (Enhaced Data rates for GSM Evolution) permite velocidades de datos hasta 384 Kbps.

Tercera generación (3G): El momento actual

3G nace de la necesidad de aumentar la capacidad de transmisión de datos para poder ofrecer servicios como la conexión a Internet desde el móvil, la videoconferencia, la televisión y la descarga de archivos. En este momento el desarrollo tecnológico ya posibilita un sistema totalmente nuevo: UMTS (Universal Mobile Telecommunications System).

La tercera generación de la Telefonía Celular se caracteriza por la alta velocidad detransmisión de datos, que repercute en mejores servicio al usuario, como serVideoconferencia, acceso inalámbrico a Internet de alta velocidad, entre varios servicios

UMTS utiliza la tecnología CDMA, lo cual le hace alcanzar velocidades realmente elevadas (de 144 Kbps hasta 7.2 Mbps, según las condiciones del terreno).

UMTS ha sido un éxito total en el campo tecnológico pero no ha triunfado excesivamente en el aspecto comercial. Se esperaba que fuera un bombazo de ventas como GSM pero realmente no ha resultado ser así ya que, según parece, la mayoría de usuarios tiene bastante con la transmisión de voz y la transferencia de datos por GPRS y EDGE.

miércoles, 18 de noviembre de 2015

Generaciones de los lenguajes de programación

Los equipos de ordenador (el hardware) han pasado por cuatro generaciones, de las que las tres primeras (ordenadores con válvulas, transistores y circuitos integrados) están muy claras, la cuarta (circuitos integrados a gran escala) es más discutible.

Algo parecido ha ocurrido con la programación de los ordenadores (el software), que se realiza en lenguajes que suelen clasificarse en cinco generaciones, de las que las tres primeras son evidentes, mientras no todo el mundo está de acuerdo en las otras dos. Estas generaciones no coincidieron exactamente en el tiempo con las de hardware, pero sí de forma aproximada, y son las siguientes:

- Primera generación: Los primeros ordenadores se programaban directamente en código binario, que puede representarse mediante secuencias de ceros y unos sistema binario. Cada modelo de ordenador tiene su propio código, por esa razón se llama lenguaje de máquina.

- Segunda generación: Los lenguajes simbólicos, asimismo propios de la máquina, simplifican la escritura de las instrucciones y las hacen más legibles.

- Tercera generación: Los lenguajes de alto nivel sustituyen las instrucciones simbólicas por códigos independientes de la máquina, parecidas al lenguaje humano o al de las Matemáticas.

- Cuarta generación: se ha dado este nombre a ciertas herramientas que permiten construir aplicaciones sencillas combinando piezas prefabricadas. Hoy se piensa que estas herramientas no son, propiamente hablando, lenguajes. Algunos proponen reservar el nombre de cuarta generación para la programación orientada a objetos.

Estos lenguajes tienen una estructura lo más parecido al idioma inglés, algunas características son:

- Acceso a base de datos.

- Capacidades Gráficas.

- Generación de código automáticamente.

- Puede programarse visualmente como Visual Basic (Programación Visual).

- Quinta generación: se llama así a veces a los lenguajes de la inteligencia artificial, aunque con el fracaso del proyecto japonés de la quinta generación el nombre ha caído en desuso.

jueves, 12 de noviembre de 2015

Software de soporte a distancia

Hay muchos programas que te permiten hacer esto, y uno de los más populares de los últimos tiempos era LogMein. Desgraciadamente, ya no ofrece su servicio gratuito, pero no te preocupes: aquí tienes 6 alternativas gratuitas para manejar tu PC estés donde estés.

Teamviewer, el todoterreno

Teamviewer, el todoterreno

Teamviewer tiene todo lo que le puedes pedir a un programa de acceso remoto, y más. La versión gratuita para uso no comercial te permite controlar otro PC, acceder a sus archivos e incluso chatear y escuchar su audio en tiempo real.

Además de tener un rendimiento muy aceptable, el punto fuerte de Teamviewer es su amplia disponibilidad: está disponible para un montón de plataformas, tanto de escritorio como teléfonos y tablets.

Weezo, el que funciona desde el navegador

Weezo, el que funciona desde el navegador

Weezo es el curioso nombre de este servicio de control y gestión remota del PC, totalmente gratuito. Tras instalar su cliente para Windows, puedes acceder a sus carpetas e incluso manejar el ratón desde una página web.

Todo funciona desde tu página de usuario en Weezo, lo cual tiene la ventaja de que no necesitas instalar nada ni recordar IP o números de usuario.

AMMYY Admin, el diminuto

AMMYY Admin, el diminuto

AMMYY Admin te salva de cualquier apuro. Este asombroso miniprograma de 400 KB no necesita instalación y sirve tanto de cliente como de servidor. En dos minutos ya lo tienes funcionando.

La principal utilidad de AMMYY Admin consiste en ayudar a algún amigo con sus problemas en el PC. Le pasas el enlace, te dice su ID, y te conectas para manejar su equipo. No obstante, también se puede instalar como servicio en tu propio PC, para que se inicie automáticamente.

VNC, el veterano

VNC, el veterano

RealVNC es el cliente y servidor de los creadores de VNC. Como Teamviewer, dispone de clientes para casi todas las plataformas y teléfonos, pero las funciones de la versión gratuita son bastante más reducidas.

RealVNC, en su versión gratuita, solo te permite controlar otro PC de forma remota, sin archivos y con otros recortes sí disponibles en las versiones de pago. Otra opción parecida esTigerVNC.

Escritorio remoto de Chrome, el de Google

Escritorio remoto de Chrome, el de Google

Esta extensión para Chrome creada por Google hace que controlar otro PC de forma remota sea muy fácil. Ambas personas deben instalarla y luego intercambiar un código numérico.

El escritorio remoto de Chrome es útil para momentos concretos, como ayudar a un amigo con algún problema en su PC, aunque también puedes habilitar conexiones remotas de forma continua.

Asistencia remota de Windows, el que no necesita nada adicional

Asistencia remota de Windows, el que no necesita nada adicional

Pero, ¿por qué instalar nada, si Windows ya trae una utilidad de acceso remoto? Lo único que necesitas es asegurarte de que está activada en elPanel de Control > Sistema > Configuración de acceso remoto.

Los tiempos en los que configurar la asistencia remota de Windows era un lio ya han pasado. En Windows 7, por ejemplo, puedes enviar fácilmente peticiones de ayuda a un amigo porcorreo electrónico.

La nube

En este tipo de computación todo lo que puede ofrecer un sistema informático se ofrece como servicio,2 de modo que los usuarios puedan acceder a los servicios disponibles "en la nube de Internet" sin conocimientos (o, al menos sin ser expertos) en la gestión de los recursos que usan. Según el IEEE Computer Society, es un paradigma en el que la información se almacena de manera permanente en servidores de Internet y se envía a cachés temporales de cliente, lo que incluye equipos de escritorio, centros de ocio, portátiles, etc.

La computación en la nube son servidores desde Internet encargados de atender las peticiones en cualquier momento. Se puede tener acceso a su información o servicio, mediante una conexión a internet desde cualquier dispositivo móvil o fijo ubicado en cualquier lugar. Sirven a sus usuarios desde varios proveedores de alojamiento repartidos frecuentemente por todo el mundo. Esta medida reduce los costos, garantiza un mejor tiempo de actividad y que los sitios web sean invulnerables a los delincuentes informáticos, a los gobiernos locales y a sus redadas policiales.

Cloud computing es un nuevo modelo de prestación de servicios de negocio y tecnología, que permite incluso al usuario acceder a un catálogo de servicios estandarizados y responder con ellos a las necesidades de su negocio, de forma flexible y adaptativa, en caso de demandas no previsibles o de picos de trabajo, pagando únicamente por el consumo efectuado, o incluso gratuitamente en caso de proveedores que se financian mediante publicidad o de organizaciones sin ánimo de lucro.

El cambio que ofrece la computación desde la nube es que permite aumentar el número de servicios basados en la red. Esto genera beneficios tanto para los proveedores, que pueden ofrecer, de forma más rápida y eficiente, un mayor número de servicios, como para los usuarios que tienen la posibilidad de acceder a ellos, disfrutando de la ‘transparencia’ e inmediatez del sistema y de un modelo de pago por consumo. Así mismo, el consumidor ahorra los costes salariales o los costes en inversión económica (locales, material especializado, etc.).

Computación en nube consigue aportar estas ventajas, apoyándose sobre una infraestructura tecnológica dinámica que se caracteriza, entre otros factores, por un alto grado de automatización, una rápida movilización de los recursos, una elevada capacidad de adaptación para atender a una demanda variable, así como virtualización avanzada y un precio flexible en función del consumo realizado, evitando además el uso fraudulento del software y la piratería.

El concepto de “nube informática” es muy amplio, y abarca casi todos los posibles tipo de servicio en línea, pero cuando las empresas predican ofrecer un utilitario alojado en la Nube , por lo general se refieren a alguna de estas tres modalidades: el software como servicio (por sus siglas en inglés SaaS –Software as a Service-) , Plataforma como Servicio (PaaS) e Infraestructura como Servicio (IaaS).

El software como servicio (SaaS) es un modelo de distribución de software en el que las aplicaciones están alojadas por una compañía o proveedor de servicio y puestas a disposición de los usuarios a través de una red, generalmente la Internet. Plataforma como servicio (PaaS) es un conjunto de utilitarios para abastecer al usuario de sistemas operativos y servicios asociados a través de Internet sin necesidad de descargas o instalación alguna. Infraestructura como Servicio (IaaS) se refiere a la tercerización de los equipos utilizados para apoyar las operaciones, incluido el almacenamiento, hardware, servidores y componentes de red .

Ventajas

- Integración probada de servicios Red. Por su naturaleza, la tecnología de cloud computing se puede integrar con mucha mayor facilidad y rapidez con el resto de las aplicaciones empresariales (tanto software tradicional como Cloud Computing basado en infraestructuras), ya sean desarrolladas de manera interna o externa.6

- Prestación de servicios a nivel mundial. Las infraestructuras de cloud computing proporcionan mayor capacidad de adaptación, recuperación completa de pérdida de datos (con copias de seguridad) y reducción al mínimo de los tiempos de inactividad.

- Una infraestructura 100% de cloud computing permite también al proveedor de contenidos o servicios en la nube prescindir de instalar cualquier tipo de software, ya que éste es provisto por el proveedor de la infraestructura o la plataforma en la nube. Un gran beneficio del cloud computing es la simplicidad y el hecho de que requiera mucha menor inversión para empezar a trabajar.

- Implementación más rápida y con menos riesgos, ya que se comienza a trabajar más rápido y no es necesaria una gran inversión. Las aplicaciones del cloud computing suelen estar disponibles en cuestión de días u horas en lugar de semanas o meses, incluso con un nivel considerable de personalización o integración.

- Actualizaciones automáticas que no afectan negativamente a los recursos de TI. Al actualizar a la última versión de las aplicaciones, el usuario se ve obligado a dedicar tiempo y recursos para volver a personalizar e integrar la aplicación. Con el cloud computing no hay que decidir entre actualizar y conservar el trabajo, dado que esas personalizaciones e integraciones se conservan automáticamente durante la actualización.

- Contribuye al uso eficiente de la energía. En este caso, a la energía requerida para el funcionamiento de la infraestructura. En los datacenters tradicionales, los servidores consumen mucha más energía de la requerida realmente. En cambio, en las nubes, la energía consumida es sólo la necesaria, reduciendo notablemente el desperdicio.

Suscribirse a:

Entradas (Atom)